【Ollama🐏】 本地LLM运行框架

对于一个大模型上线会进行 训练 -> 部署上线 -> 用户反馈 -> 微调训练 的循环, Ollama 便是简化了 部署上线 这个流程。内置模型管理与API支持。

Ollama安装部署与基本配置

(ollama提供 docker 快速部署)

window

安装

在官网下载安装程序,直接双击安装即可;如需指定安装位置,需要在cmd中运行安装程序

OllamaSetup.exe /DIR=E:\MySoftware\Ollama使用和关闭

ollama没有可视化操作界面,进程会在后台持续运行(相当于执行了 llama.exe serve),就能看到运行中的提示重启需要在任务管理器关闭进程

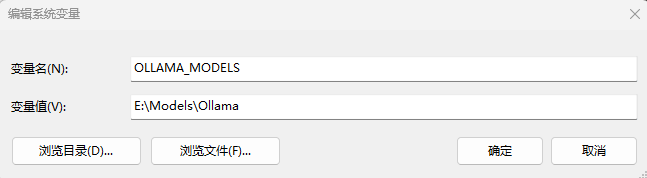

自定义模型路径

自定义模型路径需要设置环境变量OLLAMA_MODELS

之后重启进程即可

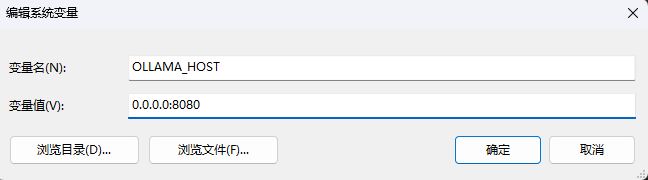

自定义API端口

默认API为 127.0.0.1:11434 , 修改环境变量 OLLAMA_HOST

LINUX

安装

一条指令没什么好说的

curl -fsSL https://ollama.com/install.sh | sh关于离线安装

因为个人工作环境基本都要离线安装/部署,补充说明相关内容

- github上下载对应架构的压缩包 https://github.com/ollama/ollama/releases/

- 解压,会在目录下

bin/与lib/加入到环境变量即可 - 如需配置service服务,copy上面脚本中的

configure_systemd()函数配置稍作修改运行即可

自定义模型路径与API

同样是修改环境变量 OLLAMA_MODELS与 OLLAMA_HOST

export OLLAMA_HOST="0.0.0.0:11434"

export OLLAMA_MODELS="/data/ollama/models"或直接修改 /etc/systemd/system/ollama.service 在[Service]后添加 Environment="..."

# ollama.service

[Service]

Environment="OLLAMA_HOST=0.0.0.0:11434"

Environment="OLLAMA_MODELS="/data/ollama/models"之后重启服务

sudo systemctl daemon-reload

sudo systemctl restart ollama注意 OLLAMA_MODELS 指定的目录需要 ollama 用户有权限

基础用法

window 和 linux 都是基于命令行的操作 直接help查看

ollama --help模型导入

linux 默认模型路径: /usr/share/ollama/.ollama/ 或 ~/.ollamawindow 默认模型路径: C:\Users\(用户名称)\.ollama

从ModelFile导入

模型文件是创建和共享 Ollama 模型的蓝图

首先,先来看看基础的格式

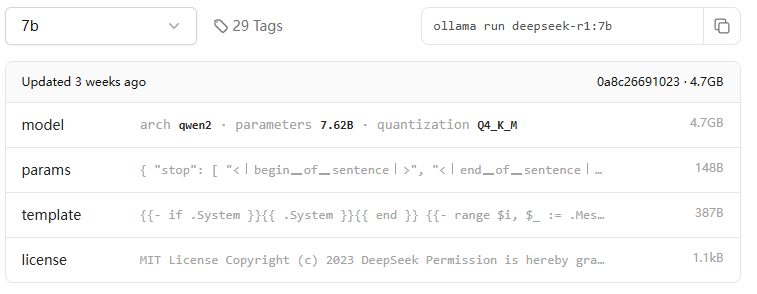

ollama run deepseek-r1:7b

>

> /show modelfileFROM /usr/share/ollama/.ollama/models/blobs/sha256-96c415656d377afbff962f6cdb2394ab092ccbcbaab4b82525bc4ca800fe8a49

TEMPLATE """{{- if .System }}{{ .System }}{{ end }}

{{- range $i, $_ := .Messages }}

{{- $last := eq (len (slice $.Messages $i)) 1}}

{{- if eq .Role "user" }}<|User|>{{ .Content }}

{{- else if eq .Role "assistant" }}<|Assistant|>{{ .Content }}{{- if not $last }}<|end▁of▁sentence|>{{- end }}

{{- end }}

{{- if and $last (ne .Role "assistant") }}<|Assistant|>{{- end }}

{{- end }}"""

PARAMETER stop <|begin▁of▁sentence|>

PARAMETER stop <|end▁of▁sentence|>

PARAMETER stop <|User|>

PARAMETER stop <|Assistant|>

LICENSE """MIT License

Copyright (c) 2023 DeepSeek

Permission is hereby granted, free of charge, to any person obtaining a copy

of this software and associated documentation files (the "Software"), to deal

in the Software without restriction, including without limitation the rights

to use, copy, modify, merge, publish, distribute, sublicense, and/or sell

copies of the Software, and to permit persons to whom the Software is

furnished to do so, subject to the following conditions:

The above copyright notice and this permission notice shall be included in all

copies or substantial portions of the Software.

THE SOFTWARE IS PROVIDED "AS IS", WITHOUT WARRANTY OF ANY KIND, EXPRESS OR

IMPLIED, INCLUDING BUT NOT LIMITED TO THE WARRANTIES OF MERCHANTABILITY,

FITNESS FOR A PARTICULAR PURPOSE AND NONINFRINGEMENT. IN NO EVENT SHALL THE

AUTHORS OR COPYRIGHT HOLDERS BE LIABLE FOR ANY CLAIM, DAMAGES OR OTHER

LIABILITY, WHETHER IN AN ACTION OF CONTRACT, TORT OR OTHERWISE, ARISING FROM,

OUT OF OR IN CONNECTION WITH THE SOFTWARE OR THE USE OR OTHER DEALINGS IN THE

SOFTWARE.

"""具体参数说明可以查看 https://www.llamafactory.cn/ollama-docs/modelfile.html#%E5%8F%82%E6%95%B0